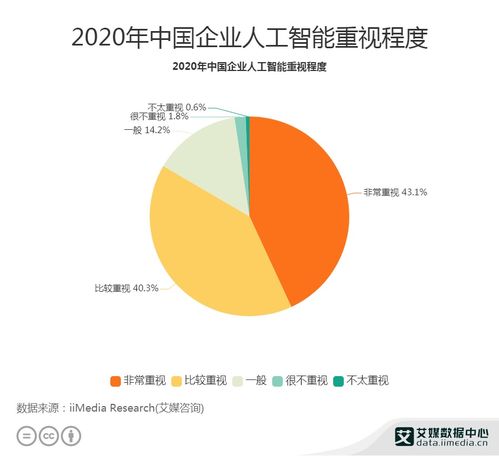

人工智能(AI)技术飞速发展,以其强大的数据处理、模式识别和内容生成能力,深刻改变了学术研究的方式。与此全球范围内涌现出大量公开、免费的人工智能公共数据集平台,为研究者提供了前所未有的便利。在技术进步与资源开放的积极叙事之下,一股暗流正在涌动:AI技术、公开数据集与日益产业化的“论文工厂”三者之间,正形成一种危险的“协同效应”,导致科研领域,尤其是部分新兴交叉学科,面临着劣质论文泛滥的严峻挑战。

一、 技术便利与资源开放的双刃剑

人工智能的“生产力革命”:以自然语言处理(NLP)和大型语言模型(LLM)为代表的AI工具,能够辅助研究者快速进行文献综述、数据分析、图表生成甚至初稿撰写。这原本是提升科研效率的福音。其“一键生成”的便捷性,也大大降低了学术不端行为的门槛。一些工具可以被轻易用于捏造数据、洗稿甚至批量生产结构完整但内容空洞的论文框架。

公共数据平台的“无门槛供给”:像Kaggle、UCI Machine Learning Repository、政府开放数据门户等平台,汇集了海量的结构化与非结构化数据。这极大地促进了研究的可重复性和跨领域探索。但问题在于,这些数据集的获取过于容易,且同质化严重。许多缺乏严谨科学问题、仅以“应用某个模型在某个公开数据集上取得微幅提升”为目标的低价值研究得以滋生。研究者可以绕过耗时费力的原始数据收集与清洗过程,直接进入“调参-跑分-写论文”的流水线模式。

二、 “论文工厂”的产业化运作

“论文工厂”是指以营利为目的,规模化、流水线式伪造或代写学术论文的非法组织。AI技术和公共数据集的普及,为这类工厂提供了完美的“生产原料”和“自动化工具”。

- 模板化生产:利用公开数据集中几个热门数据集(如MNIST, CIFAR-10, ImageNet子集),套用几种经典或稍加修改的AI模型(如ResNet, BERT变体),便可以批量制造出成千上万篇“配方论文”。其结构高度雷同:引言套用固定模板,方法部分描述轻微改动,实验部分使用公开数据跑出结果,讨论与结论泛泛而谈。

- 数据伪造与篡改变得“智能化”:AI工具可以帮助“论文工厂”更逼真地伪造实验数据、生成看似合理的统计图表,甚至自动规避常见的数据完整性检查点,使得欺诈行为更加隐蔽,难以被期刊编辑和审稿人一眼识破。

- 洗稿与规避查重:利用AI改写工具,可以快速对已有论文进行 paraphrasing,降低文字重复率,但核心思想与逻辑并未改变,生产出大量的“学术垃圾”。

三、 三方“携手”下的恶性循环

人工智能、公共数据集与论文工厂之间,形成了一个加速劣质论文产生的闭环:

- AI降低生产成本 → 论文工厂产能大增。

- 公共数据集提供标准原料 → 论文工厂无需原创数据,生产标准化、速度快。

- 海量劣质论文涌向市场 → 尤其是一些收取高额版面费、审稿不严的“掠夺性期刊”或会议,为其提供了出口。

- 低质量发表获得短期利益(如毕业、晋升、项目结题)→ 激励更多个体或机构寻求工厂服务,进一步滋养论文工厂。

- 学术界信噪比急剧下降 → 真正有价值的研究被淹没,科研人员检索和甄别文献的负担加重,损害了整个学术生态的诚信与创新活力。

四、 应对策略与未来展望

面对这一挑战,堵不如疏,需要学术界、出版界和技术平台共同努力,构建新的治理与过滤机制:

- 学术评价体系改革:推动从“唯论文数量、唯期刊等级”向重视研究原创性、实际贡献和长期影响力的多元评价体系转变。鼓励数据收集、算法创新、系统构建等多样化的科研产出。

- 出版与评审机制强化:期刊和会议应要求作者提供更详细的代码、数据(特别是处理流程)和实验日志,强制进行可重复性验证。推广“注册报告”出版模式,在研究开始前就审核其科学价值与方法,而非仅关注结果。利用AI工具本身来辅助检测论文中的异常模式、图像篡改和文本相似性。

- 数据平台的责任升级:公共数据平台可以引入更完善的数据溯源、使用追踪和贡献评估机制。对于被大量用于低价值研究的“过热”数据集,平台可以发出提示,鼓励研究者关注数据质量本身或寻找更具挑战性的新数据。

- 研究者自律与教育:加强科研伦理教育,让新一代研究者深刻理解学术诚信的底线。倡导负责任地使用AI工具,明确其“辅助”而非“替代”的定位。

###

人工智能与公共数据平台本是推动科研民主化、加速科学发现的伟大工具。但当它们与急功近利的学术评价生态和非法牟利的论文工厂结合时,便产生了扭曲的“化学反应”。破解这一困局,关键在于切断其中的利益链条,重建以质量为本的科研文化。技术本身无善恶,取决于使用它的人与制度。唯有让技术回归“服务真问题、促进真创新”的初心,才能避免学术圈陷入一场由算法和数据驱动的“垃圾泛滥”危机。